Googleが新しいAIアシスタントの起動方法に取り組んでいることがわかりました。これまでの「Hey Google」と声をかける方式をなくし、スマホを顔に近づけるだけでAIアシスタント「Gemini」が起動する仕組みです。

目次

特許で明らかになった新しい起動方法

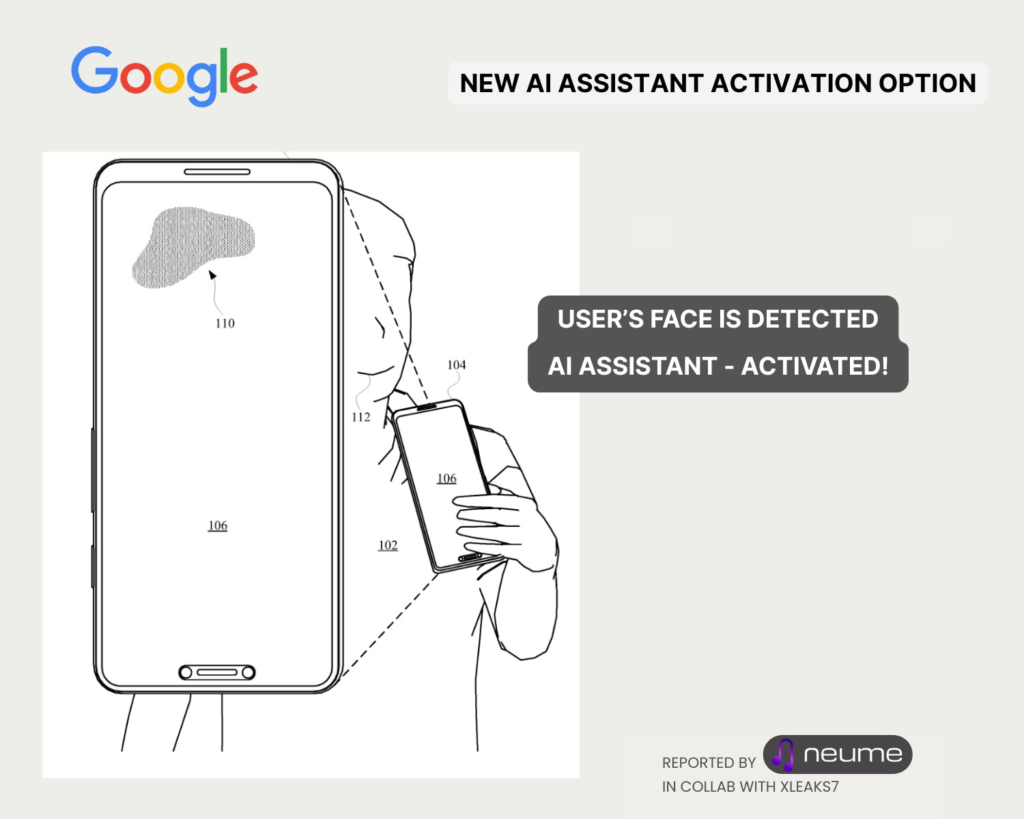

米国で公開された特許によると、Googleはスマートフォンの画面に搭載されている静電容量式センサーを活用し、ユーザーの顔の近接を検知してアシスタントを呼び出す方法を開発しています。

現在は「Hey Google」と声を出したり、ボタンを押したりする必要がありますが、この方式ではスマホを口元や顔に近づけるだけで自動的にアシスタントが反応。マスクをしているときや、周囲が騒がしい環境でも起動しやすくなるのが特徴です。

センサーの仕組みと省電力性

この技術のカギとなるのは、タッチパネルに使われているセンサーです。もともとは指のタッチを検知する仕組みですが、実は物体の接近による電界の変化も感知可能。

特許では、顔を近づけたときに広がる独特のパターンを解析し、「face-near signal」として認識する仕組みが説明されています。

さらにこの方法は低消費電力で動作するため、バッテリーを大きく消耗しないことも利点とされています。

実用化は未定ながら直感的な操作へ

今回の内容はあくまで特許段階にとどまっており、実際の製品にいつ搭載されるかは不明です。現時点では日本での導入予定も発表されていません。

ただ、Googleが「Gemini」をより自然でスムーズに使えるよう進化させようとしているのは間違いありません。声やタップに頼らず、スマホを持ち上げるだけで対話が始まる未来は、そう遠くないかもしれません。